一、准备数据 引入需用的包,并新建DataFrame例子 in [1]: import pandas as pd import numpy as np in [2]: data = pd.DataFrame(np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]]), columns=['a', 'b', 'c']) in [3]: data out[3]: a b

1.请分析SparkSQL出现的原因,并简述SparkSQL的起源与发展。 因为关系数据库已经很流行,而且关系数据库在大数据时代已经不能满足要求。首先,用户需要从不同数据源执行各种操作,包括结构化、半结构化和非结构化数据。其次,用户需要执行高级分析,比如机器学习和图像处理。在实际大数据应用

1.分析SparkSQL出现的原因,并简述SparkSQL的起源与发展。 ->SparkSQL的前身Shark对于Hive的太多依赖(如采用Hive的语法解析器、查询优化器等等),制约了Spark的One Stack Rule Them All的既定方针,制约了Spark各个组件的相互集成,所以提出了SparkSQL项目。 ->SparkSQL抛弃原有Shark的代

1.请分析SparkSQL出现的原因,并简述SparkSQL的起源与发展。 Shark提供了类似于Hive的功能,与Hive不同的是,Shark把SQL语句转换成Spark作业,而不是MAPreduce作业。为了实现Hive的兼容,Shark重用了Hive中的Hive SQL解析、逻辑执行计划翻译、执行计划优化等逻辑。可以近似的认为,Sark仅

1.请分析SparkSQL出现的原因,并简述SparkSQL的起源与发展。 因为关系数据库已经很流行,而且关系数据库在大数据时代已经不能满足要求。首先,用户需要从不同数据源执行各种操作,包括结构化、半结构化和非结构化数据。其次,用户需要执行高级分析,比如机器学习和图像处理。在实际大数据

推荐写法 参考链接 https://blog.csdn.net/u013061183/article/details/79497254

1.请分析SparkSQL出现的原因,并简述SparkSQL的起源与发展。 SparkSQL的出现,解决了对不同数据源和不同数据的操作,例如结构化和非结构化数据。还有可以支持融合关系查询和复杂分析算法。 SparkSQL的前身是Shark,Shark中提供了类似于Hive的功能。但是Shark设计中导致了两个问题

方法一:使用 tolist() /to_list()方法将 Dataframe 列转换为列表; import pandas as pd df=pd.DataFrame([ ['James', '1/1/2014', '1000'], ['Michelina', '2/1/2014', '12000'], ['

今后我们处理的数据基本上是Pandas的DataFrame和Series,其中DataFrame是Series的容器,所以需要掌握数据生成方法。现在我们学习如何制造一些简单数据放入DataFrame和Series,后面会单独讲解如何从文件(如Excel)中读取和生成数据。 2.5.1 导入Pandas 我们在使用Pandas时,另名为pd。num

一、介绍 Pandas 的基础结构分为两种: 数据框 DataFrame 序列 Series 数据框(DataFame)是拥有轴标签的二维链表,类似于 Excel 中的行列关系。 列标签为列名,行标签为索引。 iterrows() 是在数据框中的行进行迭代的一个生成器,返回每行的索引以及一个包含行本身的对象。 二、实操 建立

报错:TypeError: 'float' object is not subscriptable https://www.delftstack.com/zh/howto/python-pandas/how-to-convert-float-to-int-in-pandas-dataframe/ 转化为int之后,再用列表填充,遍历列表 k2 = pd.to_numeric(stock_a_all_pb_df.values[-1, 1:], downcast='

实际上,有一种方法可以通过向ExcelWriter传递参数来强制使用utf8编码 ew = pandas.ExcelWriter('test.xlsx',options={'encoding':'utf-8'}) sampleList = ['Miño', '1', '2', 'señora'] dataframe = pandas.DataFrame(sampl

今天使用pandas进行数据处理,由于刚入门pandans,对其中的部分操作并不是特别的熟悉,也给自己造成了不少的困扰。 当然其方便的功能与spark相比还是有很大的优势,我也感觉十分的方便。 首先是对其中mean(),describe(),sum(),count()的使用,这些函数都是对于DataFrame数据进行处理的便利函

一、数据预处理部分 (一)使用到的库 pandas Python数据分析提供了高性能,且易于使用的数据结构,即 Series 和 DataFrame。Pandas 库基于 Python NumPy 库开发而来,可以与 Python 的科学计算库配合使用。Pandas 提供了两种数据结构,分别是 Series(一维数组结构)与 DataFrame(二维数组结

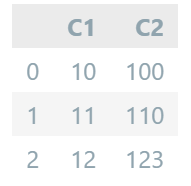

` import pandas as pd df=pd.DataFrame({'C1':[10,11,12],'C2':[100,110,123]}) df output:  iterrows():将DataFrame迭代为 (index,Series(行)) for ind

1、索引对象index pandas的索引对象负责管理轴标签和其他元数据(比如轴名称等)。构建Series或DataFrame时,所用到的任何数组或其他序列的标签都会被转换成一个Index: In [76]: obj = pd.Series(range(3), index=['a', 'b', 'c']) In [77]: index = obj.index In [78]: index Out[7

python DataFrame数据格式化 1.设置小数位数 1.1 数据框设置统一小数位数 1.2 数据框分别设置不同小数位数 1.3 通过Series设置DataFrame小数位数 1.4 applymap(自定义函数) 2. 设置百分比 3. 设置千分位分隔符 参考: python数据分析从入门到精通 明日科技编著 清华

我们先使用tf.reduce_sum来计算了每一个样本点的损失,注意这里的参数 reduction_indices=[1],这表明我们是在第1维上运算,这跟numpy或者DataFrame的运算类似,具体1的含义看下图: 缩减哪一维度,就意味着这个维度没有了,被压扁了

Pandas是一个强大的分析结构化数据的工具集;它的使用基础是Numpy(提供高性能的矩阵运算);用于数据挖掘和数据分析,同时也提供数据清洗功能。 一、数据结构 pandas的主要数据结构包括Series和DataFrame。 (1)Series 它是一种类似于一维数组的对象,是由一组数据(各种NumPy数据类型)以及一

工具类 package com.zhen.hudi.didi import org.apache.spark.sql.SparkSession /** * @Author FengZhen * @Date 3/1/22 9:34 PM * @Description SparkSql操作数据(加载读取和保存写入)时工具类 * 比如获取SparkSession实例对象等 */ object SparkUtils

一.append和assign 1.append方法 (a)利用序列号添加行(必须指定name) df_append=df.loc[:3,['Gender','Height']].copy() Gender Height 0 M 173 1 F 192 2 M 186 3 F 167 s = pd.Series({'Gender':'F','Height':188},name='new_ro

Numpy 数组的创建 np.array(data = 列表)plt.imread(图片地址)np.ones()全部为1np.linspace()创建等差数列,一维数组np.arange()创建等差数列,一维数组np.random.randint()创建任意维度的数组 常用属性 shape 返回数组的形状ndim 返回数组的维度size 返回数组元素的个数d

作者:韩信子@ShowMeAI 教程地址:http://www.showmeai.tech/tutorials/33 本文地址:http://www.showmeai.tech/article-detail/150 声明:版权所有,转载请联系平台与作者并注明出处 大家在前面的教程中看到了Pandas进行数据分析的灵活操作,但同时作为一个功能强大的全能工具库,它也能非常

作者:韩信子@ShowMeAI 教程地址:http://www.showmeai.tech/tutorials/33 本文地址:http://www.showmeai.tech/article-detail/146 声明:版权所有,转载请联系平台与作者并注明出处 当我们提到python数据分析的时候,大部分情况下都会使用Pandas进行操作。本篇为pandas系列的导语,对pandas

上一期中,通过翻译与凝练《Spark – The Definitive Guide》,我们初步解决了Spark是什么的问题,今天我们将继续学习Spark的基本架构,应用程序,结构化API,核心术语与概念,分享过程中若有错谬,欢迎拍砖。 Charpter 2.A Gentle Introduction to Spark Spark’s Basic Architecture