标签:做词 Word2Vec -- NNLM 模型 矩阵 CBOW 向量

博客配套视频链接: https://space.bilibili.com/383551518?spm_id_from=333.1007.0.0 b 站直接看 配套 github 链接:https://github.com/nickchen121/Pre-training-language-model 配套博客链接:https://www.cnblogs.com/nickchen121/p/15105048.html神经网络语言模型(NNLM)--》为了预测下一个词

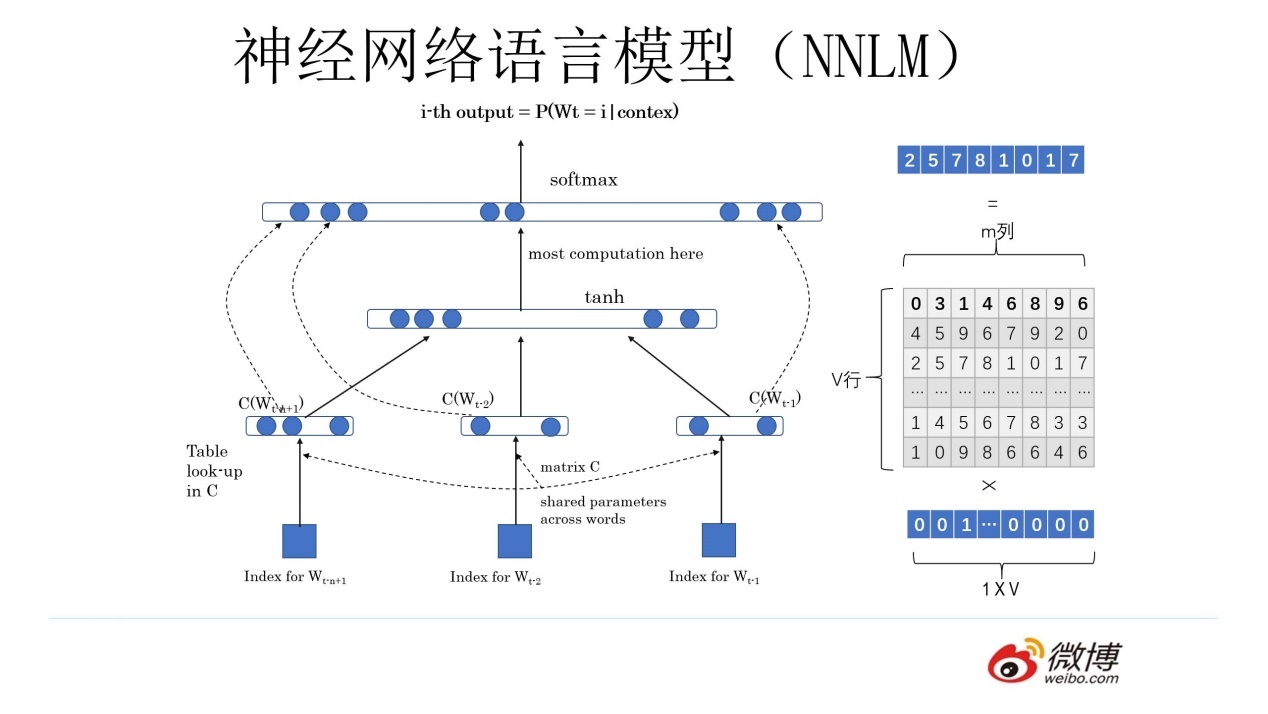

NNLM()--》预测下一个词

神经网络+语言模型:用神经网络去解决和人说话有关的两个任务的一个东西

softmax(w2(tanh((w1x+b1)))+b2)

得到一个副产品(词向量)

Q 矩阵,对于任何一个独热编码的词向量都可以通过 Q 矩阵得到新的词向量

- 可以转换维度

- 相似词之间的词向量之间也有了关系

Word2Vec --》 为了得到词向量

神经网络语言模型--》主要目的就是为了得到词向量

NNLM 和 Word2Vec 基本一致(一模一样),不考虑细节,网络架构就是一模一样

CBOW

给出一个词的上下文,得到这个词

“我是最_的Nick”

“帅” \(w_t\)

Skip-gram

给出一个词,得到这个词的上下文

“帅”

“我是_的Nick”

NNLM 和 Word2Vec 的区别

NNNL --》 重点是预测下一词,双层感知机softmax(w2(tanh((w1(xQ)+b1)))+b2)

Word2Vec --》 CBOW 和 Skip-gram 的两种架构的重点都是得到一个 Q 矩阵,softmax(w1 (xQ) +b1)

- CBOW:一个老师告诉多个学生,Q 矩阵怎么变

- Skip:多个老师告诉一个学生,Q 矩阵怎么变

Word2Vec的缺点

Q 矩阵的设计

00010 代表 apple × Q = 10,12,19

apple(苹果,)

假设数据集里面的 apple 只有苹果这个意思,没有这个意思(训练)

(测试,应用)10,12,19 apple, 无法表示这个意思

词向量不能进行多意 ---》 ELMO

标签:做词,Word2Vec,--,NNLM,模型,矩阵,CBOW,向量 来源: https://www.cnblogs.com/nickchen121/p/16470584.html

本站声明: 1. iCode9 技术分享网(下文简称本站)提供的所有内容,仅供技术学习、探讨和分享; 2. 关于本站的所有留言、评论、转载及引用,纯属内容发起人的个人观点,与本站观点和立场无关; 3. 关于本站的所有言论和文字,纯属内容发起人的个人观点,与本站观点和立场无关; 4. 本站文章均是网友提供,不完全保证技术分享内容的完整性、准确性、时效性、风险性和版权归属;如您发现该文章侵犯了您的权益,可联系我们第一时间进行删除; 5. 本站为非盈利性的个人网站,所有内容不会用来进行牟利,也不会利用任何形式的广告来间接获益,纯粹是为了广大技术爱好者提供技术内容和技术思想的分享性交流网站。